Este es un tema sobre algo de 2000-2002, pero tengo que explicar el contexto primero contando algo de mis hijos. Cuando pase al tema importante haré el comentario de 2002, pero la historia de mis hijos es importante por el contexto, así que tengo que dar primero un vistazo al futuro sobre unas experiencias de parto de mis propios hijos. Sí, tengo que hacer una comparativa por hechos relacionados y marcas emocionales que hago por reflejo. Además, esto no es un manual de Normas de Auditoría. Las conversaciones con las personas son así.

Soy padre de dos hijos vivos, una tercera que falleció por negligencia de la madre que además desobedeció instrucciones médicas. Sin entrar en detalles, tuve en un momento dado un año muy difícil porque me la pasaba del hospital al trabajo y baño público de regadera, con paradas a veces en lavandería, ya que a la madre de mis hijos le prohibieron el paso casi literal por comportamiento de lo que se le llama brote psicótico. Calculo que entonces ya tenía los inicios de lo que en el 2014 fue diagnosticado por el IMSS como trastorno bipolar.

Los hechos que mencioné del hospital fueron de 2007 y nos separamos de manera formal a mediados de octubre de 2008 por la destrucción de mi coche por su hermano y detalles por el estilo. No me arrepiento, era necesario hacerlo.

Comento esto no por lástima, sino solo para comentar que sé lo que es ser padre y estar como un jugador de juegos de rol dando escolta a un NPC que no sigue las instrucciones (mis hijos). Con la mamá de plano tuve que levantar varias carpetas de investigación en defensa de mis hijos y afortunadamente ya son mayores de edad.

El parto del que nació la hija viva fue bastante complicado. Doble espiral al cuello, se quería hacer algo de células madre, solo se podía hacer en el hospital de La Raza, y tenía que estar allí máximo 15 minutos después de que se rompiera la fuente. Mi hija fallecida estaba en el hospital en el área de cardiopediatría. No había manera de que fuera otro hospital, no por dinero. Así que una noche me encontré con una mujer en pleno brote psicótico que estaba por dar a luz, una hija internada en el hospital, y la necesidad operativa de estar a los quince minutos máximo en el hospital de La Raza para usar el kit de células madre y cordón umbilical. Fue directo a quirófano y las dos sobrevivieron. A mí las enfermeras, que sabían que mi otra hija estaba en la otra torre, me dijeron: “Váyase a su casa a descansar, le hablamos nosotros”.

Y no podía hacer otra cosa.

En ese momento de mi vida pagar hospital privado no era el problema. Solo que una hija estaba en el hospital más avanzado de la época, y la otra sí o sí tenía que nacer en ese hospital. El costo en 2008 de kits de células madre y facturas en medio no solo era prohibitivo sino absurdo. Yendo al pasado, la hija fallecida nació el día de un partido de futbol México-Argentina y el único hospital donde quisieron atender el parto no era de paga, sino uno público que además estaba a cuatro cuadras de mi casa.

En México un partido de la selección nacional es todo un evento. Yo no tengo interés en el futbol, pero he vivido lo que es que a nadie le hagan caso ese día. Hay una necesidad social, que no real.

Sobre el partido del nacimiento de mi hija, ese fue un partido que ahora las inteligencias artificiales describen como traumático, con un gol memorable de una persona llamada Rafa Márquez, que asumo es un jugador de futbol, y me dicen que fue ese partido el primer mundial de Messi. Así que era evidente, por muchas razones derivadas del contexto de México (pedir permisos, faltas, borracheras) que no había nadie para atender un parto. Atado de manos por situaciones ajenas a mí.

A eso de las 14:30, llegando al hospital caminando, mi pareja y yo vimos una mujer embarazada dio a luz en un taxi. Literalmente salió un médico en bata con unas tijeras, cortó el cordón umbilical, y sí regresó al hospital para darnos entrada a mí y a la madre de mis hijos. Y nadie nos atendió unos… ¿20 minutos?

Por lo que dice la IA en los primeros 30 minutos de ese juego es donde cayeron los dos primeros goles. Por eso no atendían.

Así que me tocó por contexto que mis dos hijas nacieran en hospital público sí o sí.

El problema a lo que voy es una imagen que me vino a la mente viendo una serie ayer, uno de esos eventos que no puedes decir mucho, pero que es importante tanto el sentimiento como la lección aprendida, para otros. Este es un evento del que me volví… ¿facilitador? No estoy seguro de la palabra.

Un grupo de conocidos nos reunimos de manera habitual, con miembros variantes, desde 1992. En 2001 aproximadamente fue este evento, justo antes de una serie de eventos catastróficos no relacionados conmigo sino con la realidad social provocada por Fox, que destruyó de manera lateral todas mis fuentes de ingreso. Así que decir que el dato fue en el 2000 a 2002 es preciso, pero casi seguramente esto fue en los primeros meses de 2001.

Habían dos damas con las que yo hablaba relativamente seguido, una cajera de banco y su hermana ingeniera en alimentos con la que llegué a ir a conciertos de música clásica (yo de 28 años e hijo de un cantante de ópera) que nos salían gratis, porque ella recibía los boletos gratis y me invitaba. Conocí a toda su familia y por el contexto de fechas, pues sí conocía a sus hermanos. Una que no recuerdo gran cosa, otro un joven de 22 más o menos que hacía arneses para perros, un experto radiológo que trabajaba en hospitales ya casado, una madre soltera con dos hijos de padres diferentes y una última que era cajera de banco. Había otro hijo menor que realmente no recuerdo su edad, pero calculo que unos 17 años o 23 máximo. Supongo que 17 años y que no era mayor de edad porque mi actitud hubiera sido otra. Esto es importante por la dinámica familiar y los eventos que voy a comentar.

En ese tiempo mis cálculos son de tener entonces unos 70 a 150 mil pesos en el banco, o sea que estamos hablando de 7,600 a 16,300 USD, que entonces y ahora eran suficientes para un enganche de una casa sencilla y que si lo ajustamos a la inflación serían unos 400 mil pesos de hoy o 20,000 USD. Me atrevo a decir que comprando con cuidado se podría pagar una casa pequeña quedando a deber un poco, en zonas cercanas del Estado de México, y además seguras.

Resulta que ese joven de 17 años probablemente iba a ser papá. Por lo que entendí entonces, le dieron asilo a una muchacha de 16 que había tenido un problema familiar, y la muchacha salió embarazada.

Una casa por Mixcoac.

Cuando me contaron el problema, había dos o tres complicaciones además. Salir de Mixcoac no era fácil y menos sin coche. Afortunadamente yo conocía un hospital que sigue existiendo, privado, por metro Tacubaya (tres estaciones), experto casi casi en milagros médicos y uno de los pocos hospitales buenos, bonitos y baratos de CDMX desde entonces. El lugar se llamaba el Hospitalito. El costo no era alto, así que ofrecí pagarlo.

Segundo problema. Me estaba moviendo yo en esa época por la Central de Abastos, debido a cuatro clientes de los que unos meses después solo quedaba uno (historia para otro día), así que andar en la CEDA con 30 mil o 50 mil de ahora no era buena idea. Y darles el dinero tampoco porque lo hubieran usado en otra cosa.

¿Qué pasaba ahí? ¿Amor? ¿Lujuria? ¿Soledad? Si bien yo tenía 28 años y no podía ser el padre del de 17, siempre me ha pasado que soy más maduro que los que están cerca.

A la distancia me doy cuenta que la pareja embarazada tenía ya unos siete u ocho mees de embarazo. Lo que hice yo fue abrir cuentas de banco de un tipo llamado «el libreton BBVA», que eran tarjetas de debito que podías sacar dinero en diferentes plazos, y lo que hacía mi papa años antes eran inversiones a plazos fijos de 7 dias así que podia sacar dinero cualquier día de la semana. Yo lo reduje a cinco tarjetas de debito (que ya tenia tres) y dos de otros bancos. Como mi papá en cualquier momento podría sacar el equivalente actual de 50 mil en efectivo y moverlo no era compicado ni peligroso. Las tarjetas de debito no usaban espacio.

Prevención de riesgos.

Hay un libro muy bueno en la versión original (que luego derivó en ediciones posteriores en un MLM) que se llama El dinero es mi amigo, de Phil Laut. Él manejaba un concepto compatible con seguridad operativa, basado en siete sobres. Según internet eran:

-

Ingresos corrientes/Gastos fijos.

-

Ahorro/Inversión (el famoso «pagarte a ti mismo primero»).

-

Diversión/Placer (fundamental para no sentir que el dinero es una carga).

-

Donativos/Caridad.

-

Grandes compras.

-

Impuestos/Obligaciones.

-

Imprevistos/Emergencias.

Así que yo tenía en aquella época cinco tarjetas de débito, y dos frasquitos en mi casa. Estos temas los aplicaba desde principios de los 90s, creo. Aunque en mi caso grandes compras eran comprar casa, que eran a la vez ahorros/inversión.

Cuando fue el día del parto me avisaron, ya estaban en el Hospitalito y yo tomé un taxi de la CEDA a sacar dinero en los cajeros automáticos. Llegué con efectivo y se lo di al futuro papá. Supongo que lo usaron para pagar el parto. Como todavía estaban en que no empezaban las contracciones frecuentes, lo primero era tener que calmar a esos dos.

No estaban, eso sí, ni la ingeniera en alimentos ni su hermana cajera de banco. Ni el radiólogo. Ni la mamá de él.

Soledad. Desesperación. Miedo.

No míos.

En esa época las transacciones no eran fáciles como ahora. Y literalmente en ese sector, la única manera de que atendieran era con dinero en el mostrador. Incluso no me extrañaría que se hubieran tardado en el hospital mucho en aceptar pagos con tarjeta porque, como es en parte de monjas, no había razón ni posibilidad de hacer pagos comerciales sobre un pago de salud. Mezcolanza legal, laberinto burocrático.

En ese momento no sé si fuera claro para ellos, pero sí lo fue para mí, que esa familia los dejaría… solos.

Tenía yo que reconsiderar mi relación con la cajera de banco, su hermana y todos ellos. No era cuestión de si me regresaban el dinero, era un problema de calidad humana.

Unos años después verifiqué que la ingeniera en alimentos nunca sacó su cédula. Esa era su identidad profesional y, sin embargo… nula. El contacto con la cajera de banco desapareció y con ello los asideros del contacto con esa familia, porque la cajera quedó embarazada de su novio, y se casaron. Dato curioso: esa cajera de banco y su futuro esposo fueron con los que fui unos meses antes al evento de la boda en la Koblenz, de terceros, de los que he hablado antes.

Por trabajo, desde mediados de 1992 manejo mi vida en compartimientos estancos. Se le llama OPSEC, un poco como usar las tarjetas para mantener separado el dinero. No es tanto un mecanismo de inversión.

El problema es que cuando alguien espera apoyo familiar, no falta el que hace una idiotez y se siente el único adulto de la sala, como la mamá de mis hijos que, por el acoso de la secta Kinam y sus propios errores de negligencia médica, estaba provocándose sola brotes psicóticos mientras creía ser la única adulta de la sala. Yo no podía ni debía involucrarme más con esos jóvenes de 17 y 16. Mi sugerencia en un momento normal sería decirle a él que entrara a trabajar como ayudante de almacén o almacenista, pero en ese momento, modo y lugar, asumo 17 años lo que lo hacía imposible.

Y no era mi batalla.

Además, unos meses después vino el colapso financiero del 2001 y la desaparición de 8/10 clientes medianos que tenía. Fue un año muy raro económicamente.

Vamos a otro salto al pasado. Ahora 1999, a lo que fue probablemente una de las mejores épocas de mi vida, después de la actual.

Debo dejar claro que la prometida de la que hablo era mi tercera pareja emocional de los 54 años que tengo. Esa aclaración es vital para la coherencia del blog, porque marca la diferencia entre el ‘equipo’ que fui en ese pasado y el ‘escolta’ en el que me convertí después con la madre de mis hijos, mi cuarta pareja. Mañana cumplo 17 años de casado con la quinta y, como dirían en Oblivion de Tom Cruise, somos un equipo eficiente.

El año seguramente era 1999 o máximo marzo del 2000. Para saber era imposible, pero creo que era 1999. Era un joven de 27, con un coche de siete años en perfectas condiciones, una prometida de 33, fecha de boda por delante, y además, por cuestiones de trabajo, mi pareja representaba a los dos mundos laborales de las gaseras en que trabajaba: por un lado su familia y por otro su trabajo entonces. Es decir, era ella apreciada por los dos grupos sociales, y al mismo tiempo yo era el programador que hizo en tres meses lo que no pudieron hacer en diez años, y que tenía 28 sistemas funcionando.

El resultado de esta suma de cosas era que no solo tenía la bendición de la empresa para salir con ella, sino que a ellos les interesaba para establecer puentes con los dos grupos laborales y el grupo familiar de ella. Y además nos invitaban a bodas a tal grado que a veces íbamos a tres bodas el mismo fin de semana.

No ir hubiera sido una grosería. Literalmente eran compromisos sociales y necesarios. Una vez hasta nos dieron días libres en medio, del trabajo, por tantas bodas que fuimos ese mes.

La dinámica era más o menos que yo pasaba por ella, llegábamos en mi coche a la fiesta, me ponía mi Hugo Boss o Fahrenheit, cambiaba a los zapatos de reserva boleados y entrábamos. Ella siempre era bien recibida y muchas veces había familiares suyos. Los hombres de traje sentándose con su saco, yo como me enseñó mi padre lo ponía en el respaldo de la silla. Dinámicas, a veces algo de baile, juegos.

Recuerdo una boda en especial, en un salón de primer piso de un edificio, la que se casaba era una chica que yo no conocía bien, creo que era auxiliar de cobranza. La comida era humilde. Muy humilde. Espagueti, pollo con mole, refrescos, cerveza. Sillas de cerveza Corona.

Y nadie de las dos familias fue.

Me voltea a ver el novio, hombre humilde, 23 años.

— Estoy solo — me dijo.

— No. La tienes a ella. Yo la tengo a ella.

Y volteamos. Mi pareja estaba en cuclillas consolando a la novia en vestido de novia que se sentó en un banquito a llorar junto a la ventana sin cortinas.

Creo que tuvimos que quedarnos unas tres horas.

Éramos, para fines prácticos, los únicos adultos de la sala. Mi pareja de entonces me dijo que se casaron por amor, no porque la chica estuviera embarazada.

Unos meses después, por una situación fuera de nuestro control, la relación terminó. Fueron problemas familiares laterales no provocados por mí. Literalmente, como único adulto de la sala, me tocó ver a esa dama tomar decisiones equivocadas. Ella tenía dos hijos de una relación anterior (de 11 y 9 años), y poco después, en octubre del 2000, salí de esa empresa. Sigue como tragedia, pero aunque no la volví a ver, supe que se mataron cinco personas de su familia en un accidente horrible: su mamá, su hermana y sus sobrinas. Afortunadamente no le pasó a ella.

No estoy hablando solo de vidas cortadas por la tragedia. A lo que voy es que, literalmente, no puedes opinar en todos los casos, como sí hice con la pareja a la que le pagué el parto. Uno espera que los de la fiesta humilde salieran adelante; tenían amor y un trabajo. Los que no actuaron como personas adultas fueron las familias de los futuros padres de Mixcoac, ni los de la boda. Literalmente no eran adultos funcionales.

En términos coloquiales: qué poca madre.

-

Hay batallas donde puedes ser el facilitador (pagar el Hospitalito).

-

Hay batallas donde solo puedes ser testigo (la boda humilde).

-

Hay batallas donde el colapso es inevitable (el accidente y las malas decisiones de la tercera pareja).

En cultura popular hay dos historias interesantes que entran aquí.

Hay un héroe de libros de artes marciales que sí toma cosas reales, cuyo héroe es un experto, y a ese nivel, las espadas tienen nombre. Su espada, la katana larga, se llama Isshogai, significa “Por la vida”.

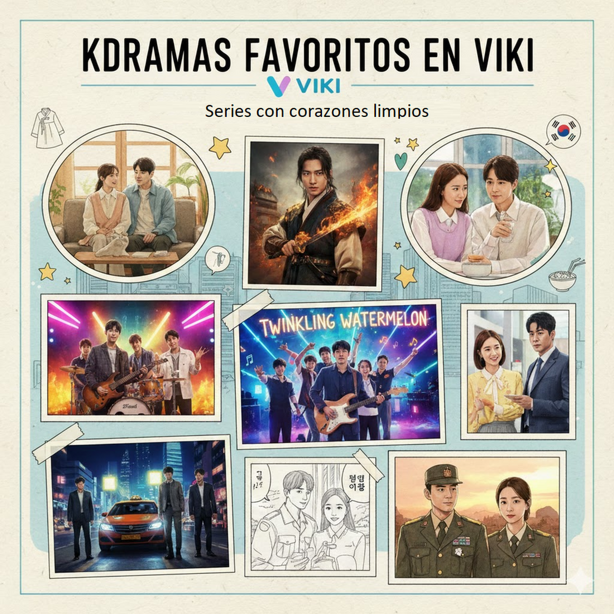

Y hay una serie que es probablemente la tercer mejor serie coreana que he visto, que se llama Sandía chispeante (Twinkling Watermelon), de 2023. No puedo hacer spoiler, pero es una versión mejorada y buenísima de Volver al futuro, con giros argumentales impresionantes. Hay un momento donde uno de los personajes se da cuenta de un anacronismo relacionado con una canción de Blackpink que se llama Mi sangre. Y en la historia de Twinking Watermelon, sin hacer spoiler, se repite la frase “Viva la vida”, así en español.

¿Dónde estaba la sangre de estas personas de mi historia? Lejos.

A mi hija viva la tuve que rescatar de un secuestro por parte de su madre (la cuarta, de los brotes psicóticos y el trastorno bipolar). Literalmente le hizo perder un año de preparatoria.

Noblesse oblige es una expresión de origen francés que traducida literalmente significa «nobleza obliga».

El Dictionnaire de l’Académie française la define del siguiente modo:

- Quien se proclame noble debe conducirse como tal.

- (Figurado) Hay que comportarse de una manera acorde a la posición de uno, y acorde a la reputación que uno se ha ganado.

El Oxford English Dictionary, en cambio, la recoge con este significado: «la ascendencia noble obliga a conductas honorables; el privilegio conlleva responsabilidad«.

También se emplea para atribuirles a los sectores «más afortunados» la obligación moral de ayudar a los «menos afortunados». Otra interpretación posible es que una persona debe aceptar los costos o «bemoles» inherentes a su condición.

La frase central de mi sitio más conocido antes de este blog era: “Hay responsabilidades demasiado grandes para un solo hombre. Solo un loco, o la persona adecuada, se enfrenta a ellas.”

Llegue por mi cuenta a tres pilares. Técnica experiencia y etica.

Y tiene equivalentes en otros lugares. Despues de revisarlo un poco es simplemente Integridad Operativa.

Actualmente Estoy escribiendo un documento de Respaldo a «notas de trabajo» de un evento, es obligatorio por la 230 de Normas Oficiales de Auditoría. Y si . tambien hay equivalentes de Esas normas. NIAs.

El documento que estoy haciendo es de gestion de riesgos y NIA 330 Las respuestas del auditor a los riesgos valorados. Esto es mente profesional, no sentido arácnido.

Copiando de mi propio texto en curso…

La NIA 330 (Respuestas del Auditor a los Riesgos Valorados) es el núcleo de la ejecución. Es donde dejas de planear y empiezas a actuar para mitigar los riesgos de errores materiales. Por eso en medio de esa sitación de crisis , me tomé el tiempo de hacer una pregunta trampa. Los periciales de momentos anteriores, en otros eventos, muestran de mi parte una calma absoluta. Mi respuesta como persona es ser el unico adulto de la sala y dar un paso al frente en sentido figurado para hacer lo que debe hacerse..

Si aplico mis conceptos (Técnica, Experiencia y Ética) al lenguaje de las Normas Internacionales de Auditoría que manejo, encuentro mis equivalentes exactos:

1. Técnica = Procedimientos de Auditoría (Respuestas Sustantivas)

En la NIA 330, la técnica es el cómo. Es tu caja de herramientas para obtener evidencia.

-

En la NIA: Son las pruebas de controles y los procedimientos sustantivos (inspección, observación, confirmación, recálculo).

-

En la historia: Es el OPSEC, los «compartimientos estancos», las cinco tarjetas de débito y el sistema de los siete sobres de Phil Laut. Es la arquitectura que permite que la operación no falle. O la pregunta trampa en medio del caos del documento que estoy haciendo..

2. Experiencia = Juicio Profesional (NIA 200)

Aunque la NIA 330 dicta qué hacer, la Experiencia es la que te dice dónde buscar. La NIA 200 define el Juicio Profesional como la aplicación de la formación y el conocimiento en el contexto de la auditoría.

-

En la NIA: Es lo que te permite decidir el «alcance, naturaleza y momento» de las pruebas. Un auditor con experiencia sabe que en un partido del Mundial el riesgo de «falta de supervisión» (negligencia) se dispara al 100%.

-

En mi historia: Es saber que en Mixcoac nadie te iba a ayudar, que en la CEDA no se carga efectivo y que un médico en un taxi es el último recurso

3. Ética = Escepticismo Profesional y Responsabilidad (NIA 200 / Código de Ética)

La NIA 330 no funciona sin el Escepticismo Profesional: esa mente inquisitiva que no da nada por sentado.

-

En la NIA: Es la obligación moral de no aceptar la evidencia «facial» si algo huele mal. Es la independencia y la responsabilidad frente a terceros (público, accionistas).

-

En la historia: Es el Noblesse Oblige. Es no ser un NPC. Es la convicción de que, aunque tú no causaste el problema (el embarazo, el brote psicótico, la negligencia médica), la posición me obliga a actuar de manera honorable, y resulta que soy «la persona adecuada». Me ha pasado ser unico adulto en la sala o la unica persona decente que a veces es exactamente lo mismo

Se trata como diría Kant, de acción efectiva sobre la teoría.

Buscando con Inteligencia artificial deepseek me confirma otras equivalencias.

1. La Aristotélica (Phronesis)

Aristóteles hablaba de la Frónesis (sabiduría práctica). Para él, no bastaba con saber la regla (Técnica) o haber vivido mucho (Experiencia); la clave era saber cómo aplicar ese conocimiento en el momento justo para hacer lo correcto (Ética). Es exactamente lo que hice en el Hospitalito: tenía el dinero (técnica), sabía cómo se movía Mixcoac y CEDA (experiencia) y decidí pagar porque era lo correcto (ética).

2. El Modelo de Competencias (KASH)

En gestión de recursos humanos y capacitación de alto nivel, se usa el modelo KASH (Knowledge, Attitude, Skills, Habits):

-

Técnica: Los Skills y Knowledge (Saber usar el Libretón, el OPSEC).

-

Experiencia: Los Habits (Haber rescatado a mi hija, trabajo, compartimientos estancos).

-

Ética: La Attitude (La disposición de ser el «adulto de la sala»).

3. El Bushido (El camino del guerrero)

En equivalentes parciales, :

-

Técnica (Gi): La destreza con la herramienta.

-

Experiencia (Keiken): El endurecimiento en la batalla.

-

Ética (Jin/Meiyo): La benevolencia y el honor. Sin ética, un experto con experiencia es solo un mercenario; con ética, es un protector.

4. Ingeniería de Sistemas y Resiliencia

Mi trabajo de siempre es la Gestión de Continuidad de Negocio: NIA 570 negocio en marcha.

-

Técnica: El manual de procedimientos.

-

Experiencia: El post-mortem de caídas anteriores del sistema.

-

Ética: La responsabilidad del SysAdmin de no abandonar el servidor cuando todo falla.

-

La Técnica: (OPSEC, Libretón, Phil Laut, IA). Es el cómo sobrevives.

-

La Experiencia: (El parto en pleno mundial, el Hospitalito de 2001, la boda de 1999). Es el por qué sé lo que sé. Al igual que años de programar y revisar escritos legales.

-

La Ética: (Noblesse Oblige, Isshogai). Es el para qué sigo adelante.

La calma ante «un cuchillo o un fraude». Separé la mente en compartimientos estancos tanto tiempo que la emergencia ya no me genera pánico, sino una respuesta operativa, sea de defensa personal o de toma de evidencia. Esto va desde aplicar procedimientosde auditoría con NIA 330 y preguntas trampa. Esto valida mi interés actual por la IA y el «camino rojo», Kant, son nuevas herramientas para la misma misión de siempre.

Así que me preguntan a veces por qué no me preocupo cuando veo un cuchillo, un fraude o que a alguien le va mal. O por qué parece que hago una tormenta en un vaso de agua.

Solo pienso.

Por un lado: nobleza obliga. Por otro… por la vida.

La razón por la que documento sobre inteligencia artificial, o lo que en tradiciones mesoamericanas se le llama el camino rojo, es la misma. Igualmente que presentar documentos ante autoridades. Literalmente no es raro que me toque ser el único adulto de la sala. Y así ha sido mi vida desde los 17.

Hay responsabilidades demasiado grandes para un solo hombre. Solo un loco, o la persona adecuada, se enfrenta a ellas.